拡張現実(AR)や仮想現実(VR)では、ユーザーが座ったり、歩き回ったりしながらコンピュータの操作が行える新しいユーザーインターフェースが求められています。

Appleは、手首の回転と腕の動きを活用したハンドトラッキング技術に関する特許を出願しました。この技術は、ユーザーの手の動きをより正確に認識し、特にXR(拡張現実)環境での操作性を大幅に向上させる可能性があります。この記事では、この特許の技術的詳細と、その応用可能性について解説します。

特許の概要

Appleが公開した特許出願(US2025/0036206 A1)では、手首の回転と腕の動きを統合的に解析するハンドトラッキング技術が詳しく説明されています。

Appleの新しいハンドトラッキング技術

Appleはこれまでにもハンドジェスチャーを活用したインターフェースを開発してきましたが、この特許では、手の動きを単純なジェスチャーの認識ではなく、手首の回転と腕の動きを組み合わせた高度なトラッキング技術として定義しています。

この技術の目的は、特にXR(拡張現実)環境でのユーザー操作の精度を向上させることにあります。

主なポイント:

- 手首の回転(Wrist Rotation)

→ 手首の軸を中心にした回転運動を検出 - 腕の動き(Arm Movement)

→ 肩や肘を基準とした大きな移動を測定 - 統合的な判定

→ 手首の動きと腕の動きを組み合わせて、より正確な操作を可能にする

どのように手の動きを認識するのか?

Appleの新しいハンドトラッキング技術は、単なるジェスチャー検出ではなく、手首の回転と腕の動きを精密に解析することに特化しています。従来のハンドトラッキング技術は、「手の位置」と「ジェスチャー」の検出に留まることが多かったのに対し、この技術は手の動きの力学的な特性に注目し、より直感的な操作を可能にします。

この技術の最大の特徴は、手の動きを単純な2D座標データではなく、3D空間の運動データとして解析する点です。そのために、Appleは以下のような独自の手法を採用しています。

3Dポジショントラッキングによる手の動きの解析

従来のジェスチャー認識では、手の位置情報を2D平面(カメラ画像)から検出するのが一般的でした。しかし、Appleの特許では、複数のセンサーを活用して3D空間における手の動きを解析することで、より正確な動作認識を実現しています。

使用されるセンサー技術:

- RGBカメラ(可視光センサー)

→ 手の形状や動きを視覚的に捉える - 深度センサー(LiDAR, ToF)

→ 手と背景の距離を測定し、正確な3D位置を取得 - IMU(慣性計測ユニット)

→ 手の加速度や回転速度を検出 - 赤外線カメラ(IRセンサー)

→ 暗所でも手の動きを正確にキャプチャ

これらのセンサーが連携することで、従来よりもはるかに高精度な手の位置と動きのトラッキングが可能になります。

重要な特定の2点をトラッキング

Appleの技術では、手の動きを解析する際に、手の中の特定の2点に注目します。

- ピンチセンターポイント(Pinch Centroid)

→ ピンチセンターポイントは、親指と指先が接触した際の中心点で、スクロールやピンチイン・アウトなどの操作の起点になります。 - 手首のピボットポイント(Wrist Pivot Point)

→ ピボットポイントは、手首の関節の中心で、手首が回転するときの基準点になります。

これらのポイントをリアルタイムで追跡することで、手の動きが単なる位置の変化なのか、それとも手首の回転を伴う動作なのかを高精度に判別できます。

例えば、スクロール動作をする際、従来のシステムでは「手全体が移動した」ことしか認識できません。しかし、本技術では手首が回転したのか、腕全体が動いたのかを識別できるため、スクロール速度や感度を適切に調整できます。

手首の回転と腕の動きを統合的に解析

この特許の最も画期的な点は、手首の回転と腕の動きを組み合わせて解析できることです。

例えば、以下のような動作をしたとします。

- 手首だけを回転(腕は動かさない)

→ この場合は、スクロール操作として認識するので細かい調整が可能になります。 - 腕全体を動かす(手首は固定)

→ この場合は、大きな移動として認識し、高速スクロールやUIナビゲーションを行います。 - 手首の回転と腕の動きを同時に行う

→ 両者を組み合わせた動作として処理します。例えば、ページスクロールしながらズームするという操作を行うことができます。

このように、手の動きを細かく分類することで、従来よりも直感的な操作を可能にします。

AIによる動作分類と適応型インターフェース

この特許には、機械学習(AI)を活用した動作認識の最適化が含まれています。

- ユーザーの動作パターンを学習し、最適なスクロール感度を自動調整

- 誤認識を減らすために動作の補正を行う(例えば、意図しない手の動きを無視)

- ユーザーごとのクセを解析し、個別に最適化されたジェスチャー設定を提供

つまり、AIを活用することにより、単純な「手の動きの検出」にとどまらずユーザーの操作性を向上させるための適応型システムとして機能するのです。

特許図面の解説

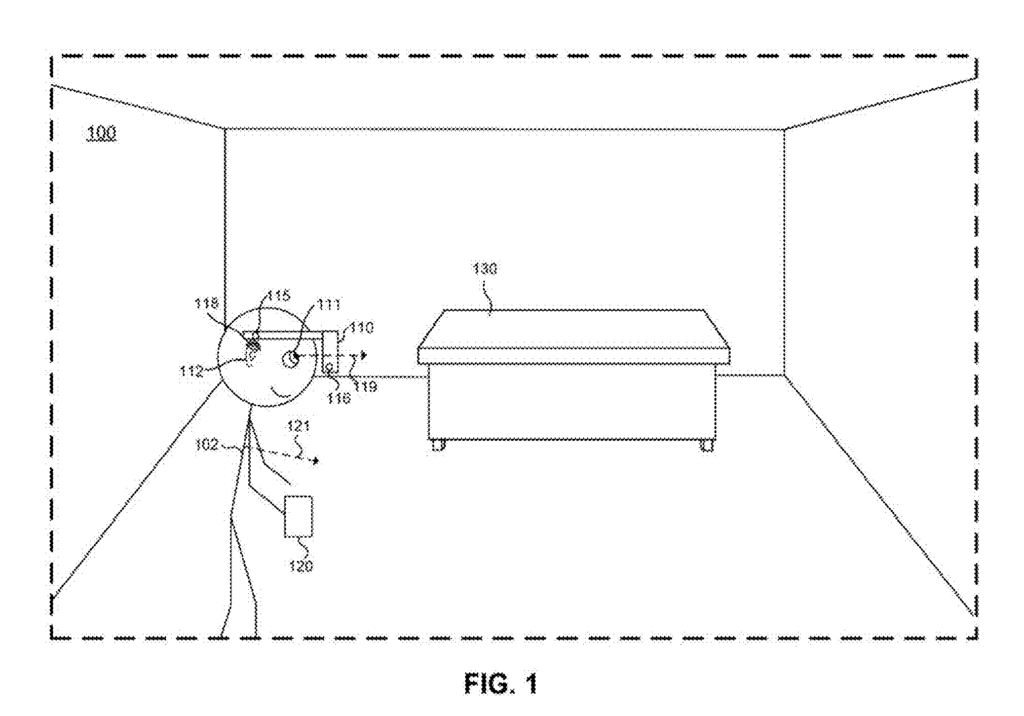

FIG. 1: 物理環境における電子デバイスの動作

FIG. 1 は、ユーザーが拡張現実(XR)環境でデバイスを使用している様子を示しています。この図では、ユーザーがヘッドマウントディスプレイ(HMD)を装着し、ハンドトラッキング技術を用いてインタラクションを行っている様子が描かれています。デバイスは、手や腕の動きをリアルタイムでキャプチャし、それに応じたUI操作が可能になります。

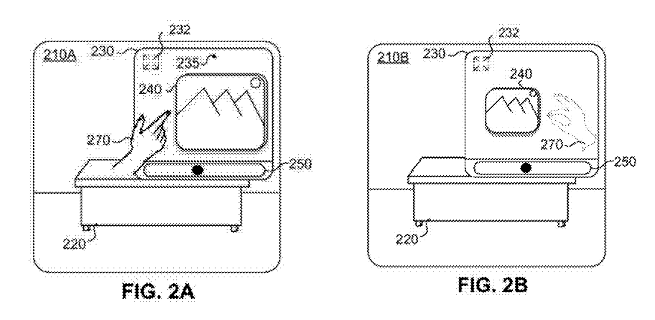

FIG. 2A, 2B: XR環境におけるユーザーインターフェース

- FIG. 2A: ユーザーが手を動かしてUIの操作を開始する場面を示しています。このとき、手の位置とその移動方向がセンサーによって追跡されます。

- FIG. 2B: ユーザーがピンチ操作を行い、UIの一部をスクロールまたは操作している様子を示しています。スクロールの方向や速度は、手首の回転や腕の移動量によって決定されます。

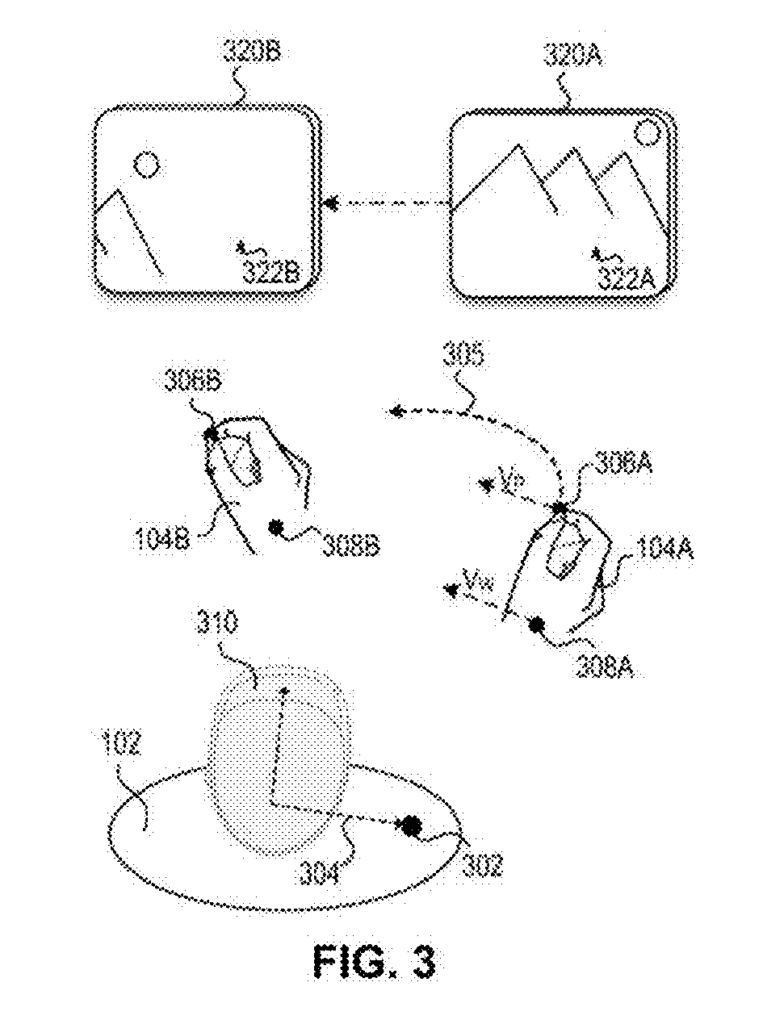

FIG. 3: 手の動きの解析

この図は、HMDがどのようにユーザーの手の動きを検出するかを示しています。

ピンチセンターポイント(指をつまんだ位置)が操作の起点となり、手首のピポットポイント(手首の間接)が回転の基準点となります。これらを3D座標として解析し、ジェスチャーの種類を判定します。

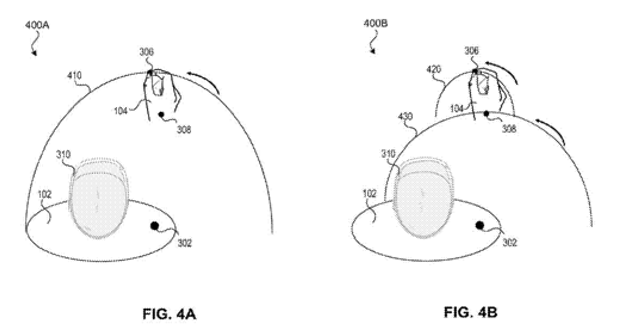

FIG. 4A, 4B: 手の動きの種類とそれに応じたトラッキング

- FIG. 4A:腕の動き(Arm Motion)を基準にした手の追跡方法を示しています。ピンチセンターが腕のピポットポイント(肩の位置)を中心に回転します。

- FIG. 4B:手首の回転(Wrist Rotation)と腕の動きを組み合わせたトラッキング方法を示しています。手首のピポットポイントも加え、より詳細な動きの解析が可能になります。

- 手首の動きなら細かく、腕の動きなら大きく操作するように、動きの種類によってUIの反応を変えるという処理を行なっています。

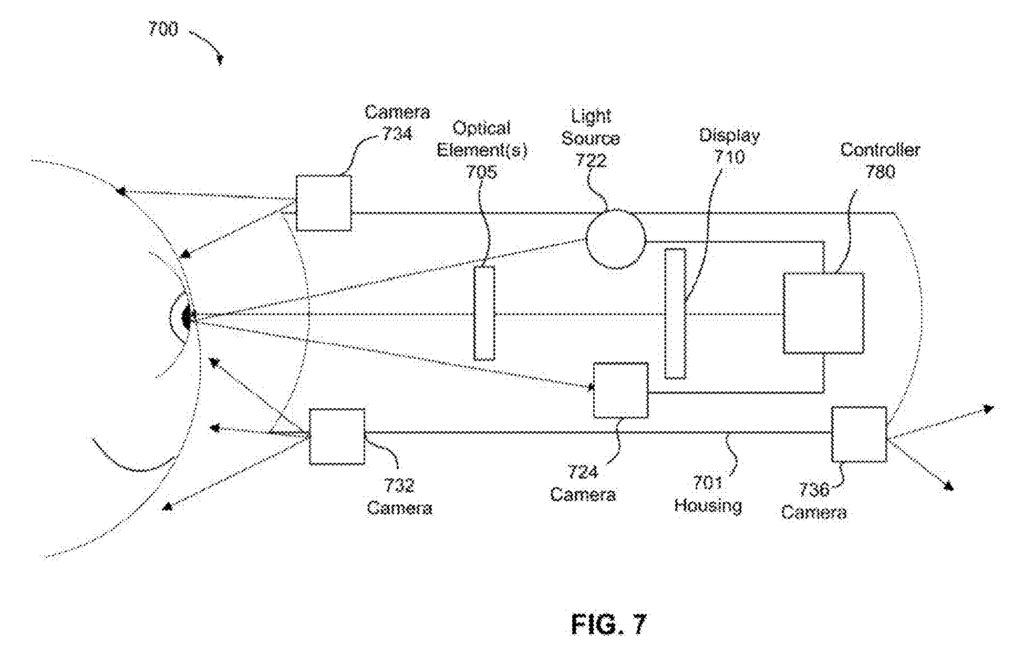

FIG. 7: ヘッドマウントディスプレイ(HMD)の構成

この図では、HMD に搭載されたセンサーやディスプレイの構成を示しています。

- カメラ724:ユーザーの視線方向を特定し、視線ベースの操作やUIの最適化に活用、また、まばたき検出、瞳孔径の変化なども解析し、ユーザーの意図を推定。

- カメラ732:環境認識用(World-facing Camera)として、ユーザーの視界にある物理環境をキャプチャ。

- カメラ734:手の動きトラッキング用(Hand Tracking Camera)であり、ユーザーの手や指の動きを認識し、ジェスチャー操作を可能にする。

- カメラ736:補助センサー(Secondary Sensor Camera)として、追加の視覚情報を提供し、他のカメラのデータを補完する。奥行き情報の強化、手の微細な動きの検出、照明条件の補正などを担当。

まとめ

Appleの「手首の回転と腕の動きを利用したハンドトラッキング」技術は、XRデバイスをはじめとする次世代のユーザーインターフェースの進化を予感させるものです。この特許が製品化された場合、より直感的で快適な操作体験が実現する可能性があります。

最後までお読みいただきありがとうございました。

特許情報

特許番号:US 2025/0036206 A1

タイトル:Hand Tracking Based On Wrist Rotation And Movement

発明者:Daniel Brewer, Yirong Tang, Chase Lortie

出願人:Apple Inc.

登録日:2025/1/30

出願日:2024/7/2

特許の詳細については、US20250036206を参照してください。

【参考記事】[Patently Apple] (https://www.patentlyapple.com)

※企業の特許は、製品になるものも、ならないものも、どちらも出願されます。今回紹介した特許が製品になるかどうか現時点では不明です。ご注意ください。