「いつも同じ味にできたらいいのに」。

料理をする人なら、誰もが一度は感じたことがある思いではないでしょうか。

Googleはこの願いを、AIとウェアラブルデバイスの力で実現しようとしています。

Googleの特許「US12380713B2 – System and Method for Smart Recipe Generation」では、スマートグラスを中心としたウェアラブルデバイスが、ユーザーの料理行動を観察して自動的にレシピを生成するという、これまでにない仕組みが提案されています。

この技術の面白い点は、単に「料理を記録する」だけではなく、「AIが料理を理解し、再現可能なレシピを生み出す」という発想にあります。

スマートグラスやスマートウォッチ、スマートフォンなどの複数デバイスを連携させ、ユーザーが手を動かしているだけで材料、分量、手順、動作を自動的に解析するのです。

このブログ記事では、この技術を特許図面とともにわかりやすく解説します。

(詳しい図面はUS12380713B2からご参照ください。)

図面の説明

Fig.3Aは、レシピ生成の一連の手順を表したプロセス図です。

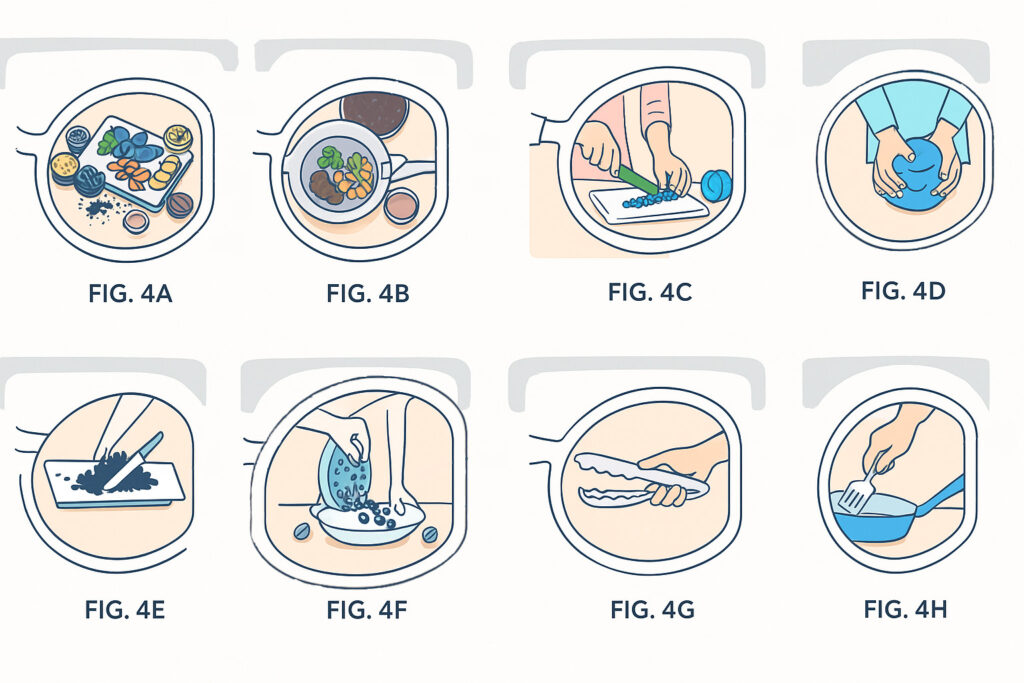

Fig.4A〜Fig.4Hは、スマートグラスを通して見ている”料理の世界”を表した図面です。

(図面はUS12380713B2からご参照ください。)

Fig.4A:材料を見分けるAI(Ingredient Identification)(図面はUS12380713B2からご参照ください。)

Fig.4Aでは、スマートグラスに搭載されたカメラが、テーブル上の食材(図中の411〜417)を撮影し(step 310)、AIがそれらを自動的に識別しています(step 355)。

例えば、トマトやタマネギ、スパイス瓶などを認識し、それぞれを「トマト100g」「タマネギ1個」「クミン小さじ1」などと判断します。

この認識エンジンは、単なる画像認識にとどまりません。材料の体積や高さ、形状からおおよその分量を推定し、さらにクラウド上のデータベースを参照してカロリー情報や栄養成分まで導き出すことができます。

料理の現場で「目分量」を使うように、AIも視覚から“分量感”をつかむ時代が来たのです。

Fig.4B:調理器具の特定(Utensil Detection)(図面はUS12380713B2からご参照ください。)

Fig.4Bでは、包丁(421)、フライパン(422)、まな板(423)など、調理に使われる器具をAIが特定しています。

スマートグラスのカメラは、器具の形状だけでなく、表面に刻まれた刻印やラベルをOCRやバーコード解析で読み取り、器具の種類や素材を特定します。

さらに、この特許では「器具と行動の関係」もAIが学習します。

たとえば「包丁=切る」「フライパン=炒める」といった関係を自動的に関連づけ、料理工程の流れを理解するよう設計されています。そして、「包丁を使ってタマネギを刻んだ」という文脈が形成されます。

ユーザーは特別な操作をしなくても、AIが視覚情報から全てを判断してくれるのです。

Fig.4C〜4H:手の動きを理解するAI(Action Recognition)(図面はUS12380713B2からご参照ください。)

Fig.4Cから4Hでは、ユーザーの手の動作を解析する仕組みが描かれています。

AIはカメラの映像から手の姿勢や動きを認識し、以下のような調理行為を分類します(step 370)。

- Fig.4C:chopping(刻む)

- Fig.4D:kneading(こねる)

- FIg.4E:mixing(混ぜる)

- Fig.4F:sprinkling(振りかける)

- Fig.4G:grabbing(つかむ)

- FIg.4H:stirring(かき混ぜる)

これらの動作は、視覚情報だけでは完全に判別できません。

そのため、スマートウォッチに内蔵された加速度センサーやジャイロセンサーも連携して、手首の動きや角度をリアルタイムで補足します。

たとえば、粉をふるうような繊細な動作も、画像と加速度データの組み合わせで正確に検出できます。

AIはこの動作データをもとに、料理の順序・時間・行為の種類をすべて記録し、完成後に自動的にレシピ化します。

料理が終わると、録画とセンサーデータをもとに、AIはレシピの名前を自動で命名します(step 391)。たとえば「スパイシー・ベジタブル・サラダ」といった表現が自然言語処理で生成されます。

さらに、Fig. 3Cのstep 392〜394では、映像にキャプション(「刻む」「混ぜる」「炒める」など)を自動挿入し、画像付きレシピとして保存されます。

こうして完成したレシピは、スマホやスマートグラスで閲覧可能になり、再現や共有も簡単です。

Fig.4I,Fig.4J:料理開始のタイミングを自動判断(図面はUS12380713B2からご参照ください。)

Fig.4IとFIg.4Jでは、AIが「いつ料理を始めるのか」を自動的に判断する仕組みが示されています。

スマートグラスやスマートフォンに搭載されたGPSが、ユーザーがキッチンに近づいたことを検出すると、システムは「レシピ記録モード」を自動で起動します。

さらに、スマートウォッチのGSRセンサー(ガルバニック皮膚反応センサー)が、「おなかがすいた」というユーザーの空腹状態を検知すると、「そろそろ調理を始めるタイミング」と判断してレシピ記録を開始します。

このように、ユーザーが何も指示を出さなくても、AIが文脈を理解して動作する点が画期的です。

Fig.1A:ウェアラブルデバイスの全体像(図面はUS12380713B2からご参照ください。)

Fig.1Aは、キッチンに立つユーザーの周囲に、複数のスマートデバイスが配置されています。

具体的には次の4つ:

- スマートグラス(100A)

- イヤホン型デバイス(100B)

- スマートウォッチ(100C)

- スマートフォン(100D)

これらのデバイスが連携し、ユーザーが気づかぬうちにレシピを作り上げていくのです。

Fig.1B, Fig.1C:スマートグラスの構成(図面はUS12380713B2からご参照ください。)

Fig.1B, Fig.1Cは、このシステムの“司令塔”ともいえる、ユーザーが着用するスマートグラスです。

スマートグラスには以下のような機能が搭載されています:

- カメラ(116):目の前の材料や動作を記録

- ディスプレイ(104):AR表示でレシピを視界に重ねる

- 音声入出力(106, 107):ハンズフリー操作

- 視線追跡装置(118):ユーザーが何に注目しているかを把握

たとえば、ユーザーがニンジンに視線を向けてそれを切り始めると、カメラが映像を捉え、視線情報と連動して「刻んでいる」という行動をAIが認識します。

この動作を解析するのが、内蔵の認識エンジン(MLモデル)です。

Fig.1D:手首の動きも補足するスマートウォッチ(図面はUS12380713B2からご参照ください。)

料理中の手の動きは複雑です。

そこで登場するのが、手首に装着したスマートウォッチ(100C)です。加速度センサーやジャイロスコープが内蔵されており、かき混ぜる・こねる・振るうといった微細な動作を検出可能です。

さらに、ウォッチには特別なマーカー(125)が取り付けられており、スマートグラスからその位置や動きを追跡することで、ユーザーの腕の正確な位置と角度まで記録できるのです。

Fig.1E:システムを統合するスマートフォン(図面はUS12380713B2からご参照ください。)

グラスやウォッチだけでは処理しきれない画像・音声・行動の認識結果の統合処理を行うのが、スマートフォン(Fig.1E)です。

大容量の演算処理が必要なときには、スマホがクラウドと連携しながら処理を担い、最終的なレシピを統合・保存する役割を果たします。

発明のポイント:レシピが「生まれる」時代

この特許の最大の特徴は、AIが人の行動を観察し、そこからレシピを“生成”する点にあります。

従来の料理アプリは、ユーザーが手入力で材料や分量を記録する必要がありました。

しかし、この技術では、AIがすべて自動的に抽出・構造化します。

AIの処理フローは以下のように整理できます。

- 画像認識で材料と器具を特定

- 動作解析で「刻む」「炒める」などの行為を分類

- 時間データから手順を再構成

- 自然言語処理モデルでレシピ名やキャプションを自動生成

つまり、視覚AIと生成AI(LLM)を組み合わせたレシピ自動生成システムなのです。

この構成により、料理行為そのものがデータ化され、完成したレシピは「再現可能な行動データ」として保存されます。

また、作成されたレシピはスマートグラス上で投影表示でき、ユーザーは自分が作った料理を再生するように見ることができます。

Googleはこの技術を、単なる家庭用ガジェットとしてではなく、創造行為をデータ化するAI基盤として開発していると考えられます。

応用可能性と今後の展望

この「Smart Recipe Generation」は、料理以外にもさまざまな分野に応用できます。

- 技能伝承や教育分野への応用

料理のように手作業を伴う職人技を、AIが映像と動作データとして記録できます。

熟練者の作業をそのまま学習データ化することで、教育現場や製造業の技能伝承にも役立つでしょう。 - 医療・リハビリテーション分野

理学療法士の手の動きを解析し、患者の運動データと照らし合わせることで、AIが最適なリハビリ手順を提示することができます。 - ウェルビーイング(心身の健康)領域

空腹やストレスなどの生体情報と行動データを組み合わせることで、「癒しの料理」や「ストレス軽減メニュー」といった新しい健康提案も可能になります。

Googleはこれらの技術をウェアラブルAIプラットフォームとして展開しようとしているようです。

スマートグラスは、もはや情報を見るためのデバイスではなく、人間の知覚を拡張するセンサーとしての役割を担っていくでしょう。

まとめ

- Googleの特許「US12380713B2」は、スマートグラスを中心に、材料・動作・時間を解析して自動的にレシピを生成する技術です。

- この技術は、料理行為そのものをデータ化し、創造行為を再現可能にするAI基盤へと発展する可能性があります。

- 料理だけでなく、工芸やDIY、介護や保育など「手の動き」が重要なあらゆる分野へと応用される可能性があります。

最後までお読みいただきありがとうございました。

特許情報

特許番号:US 12380713 B2

タイトル:System and Method for Smart Recipe Generation

発明者:Omar Estrada Diaz

出願人:Google LLC

公開日:2025/8/5

出願日:2022/9/14

特許の詳細については、US12380713B2を参照してください。

※企業の特許は、製品になるものも、ならないものも、どちらも出願されます。今回紹介した特許が製品になるかどうか現時点では不明です。ご注意ください。